公开于学术机构的研究数据,正演变成重要的信息资源,然而,对于这些犹如宝藏般的数据,该如何进行有效的利用,众多的人依旧未能找到进入的门径。能够掌握系统化的获取以及处理方法,可使得普通的研究者同样能够依托于高质量的数据去展开分析,进而避免陷入从头摸索的艰难境地。

数据资源的公开渠道

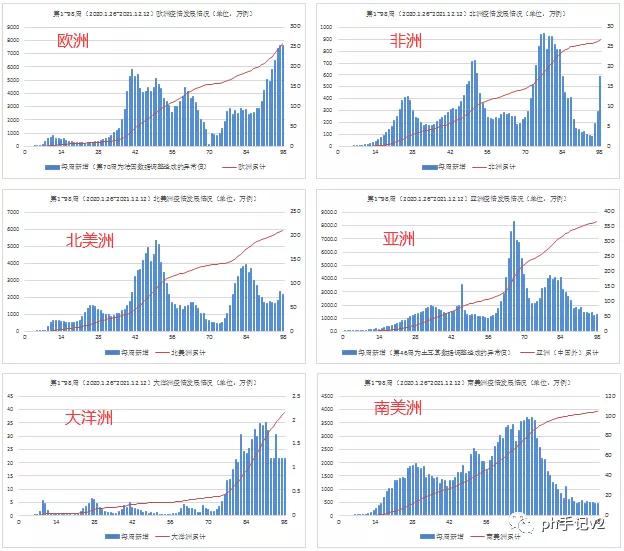

在国内外,顶尖科研的那些团队,常常会去共享他们所曾进行研究的数据,哈佛大学维持公共卫生学院的状态之下存在的相关COVID - 19数据仓库,约翰斯·霍普金斯大学发布的全球范围内疫情有着统计内容之事,都收纳记录了详细内容,其中包括武汉在内的历史记录情况,这些所形成的数据集在通常情况之下,都经历过初步的整理,具备着比较良好呈现出来的结构性。

曾有国内机构,像是复旦大学公共卫生学院,发布过经过去标识化处理的疫情统计分析数据。这些学术数据,和单纯的病例数字相比,常常含有更丰富的维度,比如说病例分型、传播链信息等,这为深入分析创造了可能。

专业化数据平台的价值

国家人口健康科学数据中心构建了专门的 COVID - 19 数据库,该数据库汇集了多源数据,其中包含了对武汉早期疫情时间序列信息的整合,这类平台的核心优势在于已然完成了多源异构数据的清洗、对齐以及标准化。

存在像丁香园这般的实时动态平台,虽说前端大体都是以可视化图表作为主要呈现,但它的后台常常会为开发者供应接口以供其去获取原始数据,依凭这些接口,用户能够越过繁杂的采集以及清洗步骤,直接得到能够导入Excel加以分析的结构化表格,从而使其效率大幅提高。

自主采集的技术方案

对具备技术背景的用户而言,自己来编写爬虫去采集公开数据是个可行的方案,运用Python的Requests库能够抓取网页,BeautifulSoup库可以解析页面进而提取所需数字以及文本,最终借助Pandas库把整理好的数据导出成Excel文件。

被采之时,务必得遵循所设置得规则,得敬重网站所拥有的robots协议,好好地去设置访问间隔,防止给目标服务器带去过大压力,针对借由JavaScript动态加载的数据,有可能则需借助像Selenium这般的工具来模拟真实浏览器操作才能够完整地获取到。

数据清洗的关键步骤

常有原始数据存在着缺失、重复或者格式混乱的状况,Excel所内置的Power Query工具特别适宜去完成此类清洗工作,它能够对空白单元格开展高效处理,还能合并重复记录,并且会把日期等字段统一转变成标准格式。

关于分类信息,像患者类型、所属区域,得构建统一的编码体系。与此同时,要运用统计办法识别异常值,比如借着箱线图或者计算标准差,找出显著偏离正常范围的记录,并且核查修正,这可是保证后续分析质量的基础。

数据的组织与管理

疫情数据具备强烈的时间属性,依照时间序列来进行组织是最为直观的,在Excel当中,当以日期列当作主键,把每日新增确诊、累计确诊、治愈人数等指标作为并列字段,运用“表格”功能开展结构化引用,从而便于公式自动扩展。

在碰到周报或者月报这类并非以日为粒度的数据之际,为了能够开展连续分析,常常需要借助插值之类的方法把那些数据转化成日度数据。与此同时,要是数据涵盖了地理信息,那么就可以依据武汉的各个区(像是洪山区、江汉区)来进行分表管理,以此方便后续的对比以及空间分析。

数据的验证与安全

数据溯源机制的建立是极其关键重要的,要单独去维护一张记录表格,清晰注明每个数据的来源网址、收集时间以及更新状态,借助Excel的数据验证功能,针对数值字段设定合理范围,像确诊数不能为负数,以此来防止输入出现错误。

任何涉及个人或者敏感信息的那些数据,都得开展严格的脱敏以及聚合处理才行,要保证没办法识别出特定的个体。在进行数据分析以及报告的时候,一定要注明数据是来自哪里,要客观地去呈现结果,这是科研伦理的基本要求,同样也是对于数据背后个体的尊重。

当你运用公开数据开展研究的时候,可曾碰到过有关数据质量或者来源可信度层面的那种棘手难办的问题?欢迎于评论区去分享你的经历以及对应的解决方案。要是本文对你产生了帮助的话,请给予点赞予以支持。